mydns.jpに繋がらなくなった。

事の発端

先日、mydns.jpからメールが来た。IPアドレスの通知が10日間確認できません。

※注意

・一週間以上IPアドレスの通知がないと、エラーサイトに誘導します。

・一ヶ月以上ご利用がないと、全てのデータを削除しますのでご注意ください。

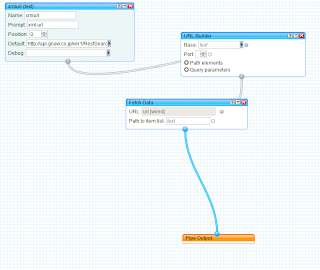

ipアドレスの通知は、30分おきにwgetコマンドでログインページにアクセスすることで行なっている。

確かに、mydns.jpのログを見るとアクセス履歴がない。どうやら、サーバーからmydns.jpへの接続がうまく行ってないらしい。

結論

悪さをしていたのは、iptablesだった。一度/etc/rc,d/init.d/iptables stop

で止めた上で

ping www.mydns.jp

を叩いたら繋がった。一先ず、接続許可リストにwww.mydns.jpを加えて問題解決。しかし、色々と腑に落ちない。

やったこと

まずは、pingを試してみる。

ping www.mydns.jp

は勿論、直接IPアドレスをターゲットにしたりもしたけどどうやら駄目。

次はtraceroute

見事に途中まで行って繋がらなくなっている。

この辺で困る。

routeコマンドでルーティングテーブル眺めたり、/etc/hostsとか/etc/resolver.confを眺めるも特に問題無さそう。

というか、mydns.jpにのみ繋がらない。

この辺で、@masawada君に頼んで彼のtracerouteの結果を見せてもらった。

どうも、mydns.jpの直前までは繋がっているらしい。と言うことはルーティングテーブルやDNSの設定ではないなー

って感じで悩んでて、ふとファイアーウォールかなー?と。

そういう訳で、iptablesの設定を変更してどうにか解決。

原因??

なんで、mydns.jpが弾かれていたのか結局謎。

接続拒否リストに載っていたとかってこともないし、特にブロックする設定にしていたわけでもない。

以前発生した似たような現象で、許可していない場所から、場所へのアクセスを全て弾く設定をしてしまっていたことがあったけど、今回はそういう事もない。

ただ1点気になるのはiptablesの設定ファイルの中に書いた

iptable -A INPUT -t filter -p tcp --syn -j DROP

コレが俺の思っている以上に強力なのではないだろうか。特に設定をしていないtcpパケットは弾くっていう意味で書いているつもりだけど、ぜんぜん違うのでは・・・?

iptables -L

を叩くと

Chain INPUT (policy ACCEPT) target prot opt source destination ACCEPT all -- jpn.www.mydns.jp anywhere ACCEPT all -- eu.www.mydns.jp anywhere ACCEPT all -- usa.www.mydns.jp anywhere ACCEPT all -- asia.www.mydns.jp anywhere ACCEPT all -- yoriko.mydns.jp anywhere ACCEPT all -- yoriko.mydns.jp anywhere ACCEPT all -- usa.www.mydns.jp anywhere ACCEPT all -- asia.www.mydns.jp anywhere ACCEPT all -- www.MyDNS.JP anywhere ACCEPT all -- eu.www.mydns.jp anywhere DROP all -- usa.www.mydns.jp anywhere DROP all -- asia.www.mydns.jp anywhere DROP all -- www.MyDNS.JP anywhere DROP all -- eu.www.mydns.jp anywhere ACCEPT tcp -- anywhere anywhere tcp dpt:ssh ACCEPT udp -- anywhere anywhere udp dpt:ssh ACCEPT tcp -- anywhere anywhere tcp dpt:http ACCEPT udp -- anywhere anywhere udp dpt:http ACCEPT tcp -- anywhere anywhere tcp dpt:nnsp ACCEPT udp -- anywhere anywhere udp dpt:nnsp

ってなって、mydns.jpをDROPしてるし・・・?わからん・・・。わからんけど、今日は寝る。